Depth Up-Scaling

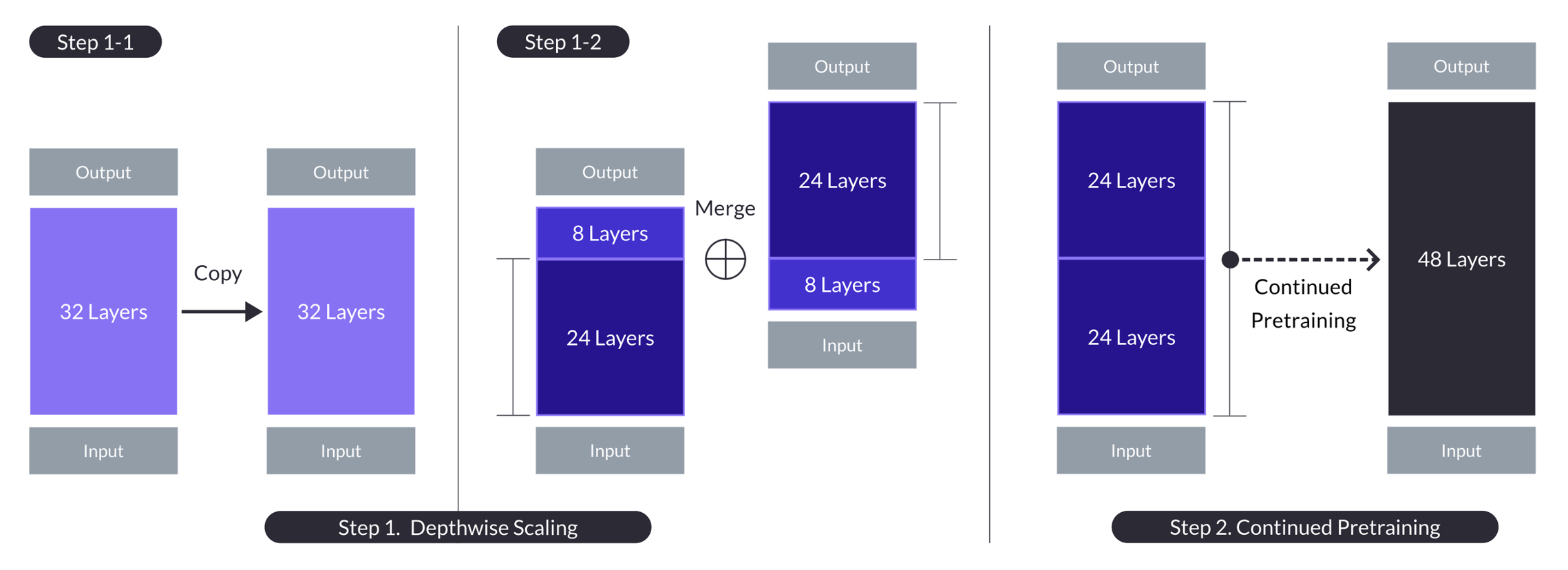

L’article de SOLAR10.7B introdueix l’augment de profunditat “Depth Up-Scaling” (DUS) com a competència a la mescla d’experts “mixture-of-experts” (MoE). Es basa en una idea senzilla: agafar un model existent, duplicar-li les capes i preentrenar-lo contínuament “continued pretraining” perquè doni millors resultats. El problema rau en la concatenació de l’última capa del model original amb la primera capa del seu duplicat. Per facilitar l’entrenament continuat del model resultant, els autors eliminen les \(m\) capes finals del model original i les \(m\) capes inicials de la còpia. Mitjançant aquesta tècnica, després de la concatenació, el model pateix una caiguda de rendiment inicial, però es recupera ràpidament durant la fase continuada de preentrenament.

Tot i que els autors no ho diuen, eliminar les capes inicials i finals té sentit des del punt de vista de la interpretabilitat mecanicista “mechanistic interpretability” (vegeu el fil d’Anthropic sobre “transformer circuits”), atès que la primera i la darrera capa tenen tasques especialitzades.

Els autors utilitzen Mistal 7B, amb una arquitectura Llama 2 de 32 capes, com a model base. Prenen \(m=8\), de manera que el model resultant té \(2*(32-8)=48\) capes. No proven altres opcions per \(m\), així que ben segur apareixeran millores del mètode en un futur pròxim.

Nous Research ja ha entrenat un model Hermes 2 a sobre de SOLAR10.7B, i sembla que funciona molt bé.